IJCAI 2025(The 34th International Joint Conference on Artificial Intelligence)将于2025年8月16日至22日在加拿大蒙特利尔举行。IJCAI是人工智能领域最具影响力的国际会议之一,也是中国计算机学会(CCF)推荐的A类国际学术会议,会议内容涵盖了人工智能理论与架构、机器学习、自然语言处理、计算机视觉、机器人科学等领域。

论文题目:Latte: Transfering LLMs’ Latent-level Knowledge for Few-shot Tabular Learning

第一作者:石儒学(2024级硕士研究生),顾恒瑞(2022级硕士研究生,共同第一作者)

收录会议:IJCAI 2025(CCF-A类)

指导教师:王鑫

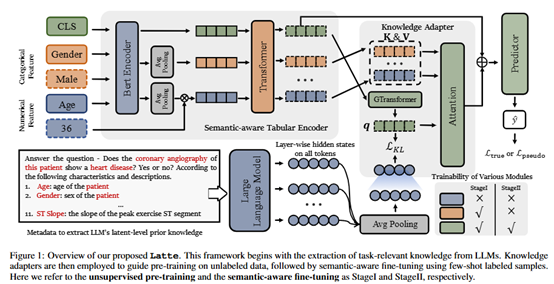

论文概述:少样本表格学习(其中机器学习模型使用有限数量的标记数据进行训练)为解决现实世界的挑战提供了一种经济高效的方法。大型语言模型(LLMs)的出现引发了人们对利用其预训练知识进行少样本表格学习的兴趣。尽管取得了可喜的结果,但现有的方法要么依赖于测试时知识提取,这会引入不希望的延迟,要么依赖于文本级知识,这会导致不可靠的特征工程。为了克服这些局限性,本文提出了一种训练时知识提取框架Latte,该框架将LLM内的潜在先验知识转移,以优化更通用的下游模型。Latte支持一般知识引导的下游表格学习,促进不同特征值之间的信息加权融合,同时降低对有限标记数据过度拟合的风险。此外,Latte与现有的无监督预训练范式兼容,并有效地利用可用的未标记样本来克服极小标记数据集带来的性能限制。对各种少样本表格学习基准的广泛实验证明了所提出方法的卓越性能。

Latte框架图: