人工智能学院博士研究生黄思理的论文《Generalizable Causal Reinforcement Learning for Out-of-distribution Environments》被SCI一区期刊TII接收。TII全称为IEEE工业信息学汇刊(IEEE Transactions on Industrial Informatics),是IEEE旗下的顶级学术期刊,专注于工业信息学领域,涵盖工业自动化、物联网、大数据分析和人工智能等技术在工业中的应用。

黄思理同学是强化学习项目组成员,一直从事深度强化学习、迁移学习相关的研究工作,本篇工作由杨博、陈贺昌老师共同指导,同时与清华大学的崔鹏老师、美国里海大学(Lehigh University)的Lichao Sun老师合作完成。

论文详情:

题目:Generalizable Causal Reinforcement Learning for Out-of-distribution Environments

第一作者:黄思理

期刊名称:IEEE Transactions on Industrial Informatics (TII)

期刊类别:中科院1区

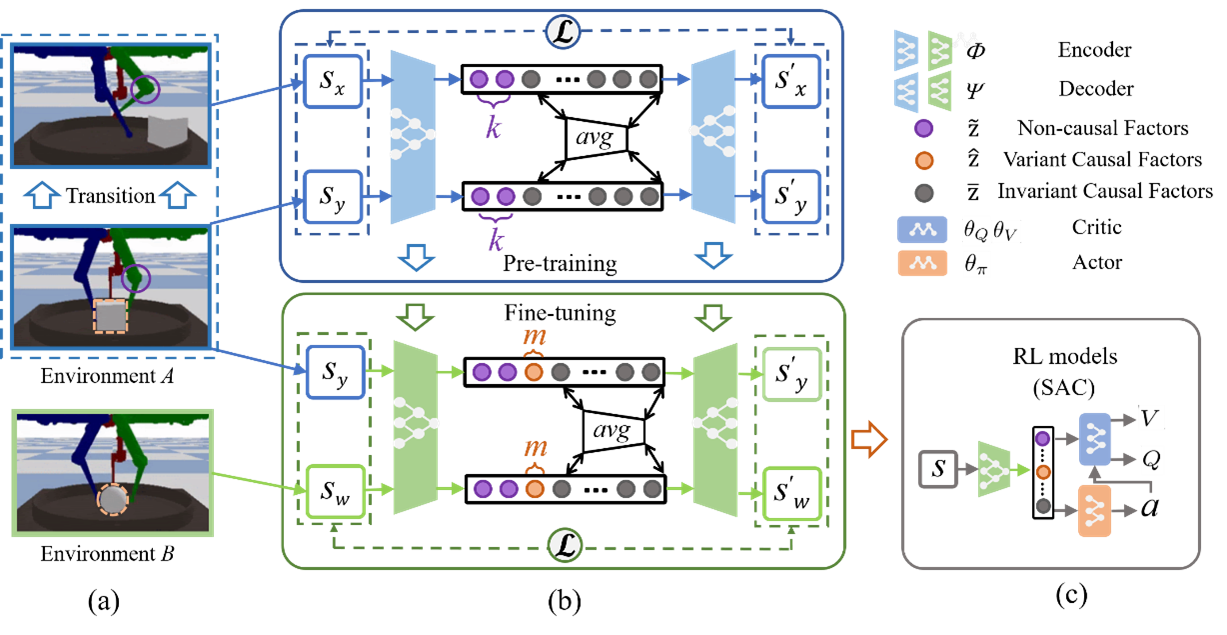

论文概述:分布外(Out of Distribution, OOD)泛化是将强化学习算法应用于实际应用的关键。为了解决OOD问题,最近的工作重点是通过捕捉影响环动力学的因果因子来学习OOD适应策略。然而,这些工作仅以纠缠或二元形式恢复因果因子,实现的泛化需要来自测试环境的额外数据。为了打破这一限制,本文提出了可泛化因果强化学习(Generalizable Causal Reinforcement Learning, GCRL),用于学习因果因子的解纠缠表示。在此基础上,本文训练了无需额外训练即可实现OOD泛化的策略。为了捕获因果因子,GCRL部署了一个带有两阶段约束的弱监督信号,以确保解耦所有因子。然后,为了通过因果因子实现OOD泛化,GCRL建立了动作对表示的依赖关系,并跨多个环境对策略模型进行了优化。实验结果表明,当学习到的策略能够解决训练环境中的目标任务时,所建立的依赖恢复了因果因子与行为之间的正确关联,并在因果世界和Mujoco的八个基准上实现了OOD泛化。

图1 GCRL框架